Mange store teknologiselskaper har allerede investert tungt i kvanteteknologier, men betydelig bruk av kvantedatabehandling har hatt sin del av forsinkelser og feilstarter. Men med noen nylige kunngjøringer i kvantesektoren, ser det nå ut til å være det ideelle tidspunktet for organisasjoner å se nærmere på kvante og vurdere hvordan denne tilnærmingen kan fungere for deres arbeidsbelastninger. Organisasjoner som historisk har vært fokusert på klassisk databehandling, posisjonerer nå kvante for fremtiden.

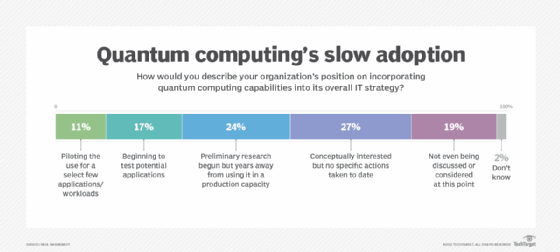

I en ESG IT-utgifter undersøkelsen indikerte 11 % av respondentene at organisasjonene deres testet kvante for noen få applikasjoner, 17 % indikerte at de tester og 24 % av respondentene har begynt forskning, men er år unna produksjonsapper. Til slutt har 27 % uttrykt interesse for kvanteberegning, men har ikke tatt noen tiltak for å omfavne det.

Denne langsomme veksten i adopsjon er i ferd med å endre seg – og muligens raskt. Ettersom ledende organisasjoner utforsker nye måter å produsere raskere resultater, akselerere kjøpssykluser og forbedre ytelsen på, har de blitt mer åpne for å skifte bort fra rent klassiske løsninger for å akselerere innføringen av kvante.

Det dynamiske skiftet og markedstilpasning

Industrien oppdager også nye metoder og brukstilfeller som kan brukes fra klassiske til kvantedatabehandlingsplattformer. Ta for eksempel den nylige fusjonen mellom Quantum Computing Inc. (QCI) og QPhoton, et kvantefotonikselskap. Bill McGann, COO og CTO ved QCI, diskuterte fusjonen.

Basert på informasjonen han delte, ser det ut til at kombinasjonen av QCI- og QPhoton-evner kan levere en kvantedatamaskin som gjør kvantesystemer mer tilgjengelige for organisasjoner, slik at de kan se forretningsresultater raskere og mer kostnadseffektivt. En annen fordel med denne fusjonen er at selskapene utvider brukerbasen til ikke-kvanteeksperter, hvorav mange har ventet spent på muligheten til å utforske kvante-mulige problemer på områder som analytisk optimalisering og oppdagelse av narkotika.

Ved å bruke en full-stack-tilnærming, tilbyr QCI og QPhoton sammen en unik mulighet til å akselerere leveringen av praktiske kvanteapplikasjoner. Dette er den samme prosessen som drev verdi i klassisk databehandling. Sammenslåingen av de to selskapene utvider QCI-porteføljen for å hjelpe til med å akselerere tilgjengeligheten til kvantedatabehandling for dagens brukstilfeller, for eksempel AI og optimalisering. Dette gjør det også mulig for kvanteberegning å operere ved romtemperatur, noe som ofte er en utfordring med denne typen databehandling.

Klassisk vs kvantebrukstilfeller

Når det gjelder brukssaken for finans, er en måte å forstå hvordan man kan svinge fra klassisk til kvanteberegning å tenke gjennom hvordan algoritmer fungerer.

Ta for eksempel en tradisjonell investormodell. Med en finansiell algoritme må du forstå og se på forhåndsdefinerte brukerparametere, som investeringsmål, risikotoleranser og mangfold av fond. I dette scenariet ønsker investoren å forstå brukerens investeringspreferanser og risikotoleranser. Disse dataene er “parametrisert“- betyr at variabler opprettes og sendes videre til kvanteberegningsmodellen, som kan bruke en kunstig intelligensmodell brukt av den kvantekompatible Monte Carlo-algoritmen eller andre teknikker for å behandle investorens instruksjoner, analysere de globale aktiva-universets stokastiske data og produsere tilsvarende resultater for investorforespørsler.

Et annet fremvoksende fokus eller konsept som kommer ut av investormodellen er å gjøre det mulig for brukere å autonomt behandle og analysere stokastiske data om finansielle eiendeler. Et grensesnitt – proprietært eller ikke – kan gjøre det mulig for brukere å gi forhåndsdefinerte inputparametere som representerer deres investeringspreferanser og risikotoleransenivåer, og deretter produsere uavhengige tilpassede løsninger for hver bruker.

Avhengig av typen brukerhenvendelse eller forespørsel om analyse, en versjon av AI — slik som autonom spredningsanalyse eller autonom diversifisering og allokeringsmaskinlæring — kan distribueres for å behandle instruksjonene og analysere stokastiske data. Denne prosessen vil være svært vanskelig å oppnå i klassiske datamiljøer.

Quantum: I horisonten

Som IBMs sjefkvanteeksponent Robert Sutor forklarte i en blogg innlegg fra juli i fjor, “kvantedatamaskiner vil løse noen problemer som er helt upraktiske for klassiske datamaskiner.” Dette indikerer at organisasjoner planlegger å ta i bruk quantum i sine eksisterende miljøer.

“[QCI is committed to be the] demokratiserende kraft som gir ikke-kvanteeksperter makt til å realisere kvanteverdi,” sa Robert Liscouski, administrerende direktør i QCI. Det nylige oppkjøpet av QPhoton akselererer denne brukervennlige tilnærmingen.

Her er noen tanker du bør vurdere:

- Kvanteberegning er den neste logiske utvikling fra høyytelses databehandling (HPC) når det gjelder brukstilfeller.

- Det finnes maskinvaretilnærminger — IBM og Honeywell, for eksempel — og programvaretilnærminger — f.eks. Google, AWS — til kvanteberegning.

- Leverandører har jobbet med noen av deres spesifikke kompetansesentre og gjort omfattende undersøkelser fra CTO-kontoret.

- Toppleverandører som leder dette initiativet er IBM, QCI, Xanadu, Microsoft Azure Quantum og D-Wave Systems.

Selv om det fortsatt er tidlig for kvantedatabehandling, ser leverandører på dette området – som HPE, Dell og IBM – noen interessante bruksområder, og de utforsker dem med partnere og kunder. Hvis de kan koble kvantedatamaskiner med HPC-systemer, tror han kvantedatamaskiner kan akselerere visse arbeidsbelastninger. I denne modellen kan kvanteberegning bli en akselerator koblet til et standard HPC-system.

Så hvem i bedriftens IT kjøper kvanteløsninger? Ifølge kvanteselskaper er dataforskere innen utdanning, vitenskapelige laboratorier og forskere de primære brukerne, mens vanlige kjøpere inkluderer flyselskaper, finansinstitusjoner og akademia. Samtalene fokuserer på de fem beste applikasjonene for innledende kvante, som inkluderer, men ikke er begrenset til, følgende målrettede sektorer: optimalisering, forskning, krypto, finans, materialvitenskap og helsevesen.

Å gjøre grep i markedet

Microsoft gjør fremskritt med Azure Quantum uten store investeringer i maskinvare. Disse emulatorene har også et konsortium av selskaper som støtter dem. QCI, Honeywell, Toshiba, IonQ og iCloud er leverandører som diskuterte deres tilnærming ved å bruke Azure for å nå målene sine.

Google Quantum AI er for det meste basert på en simulator, men fremgangen har avtatt siden den første lanseringen i 2019. Sycamore-datamaskinen viser potensial, men er fortsatt i et tidlig stadium. Amazon Web Services har et kvanteberegningssenter fokusert på FoU, testing og drift av kvanteprosessorer for å innovere og skalere teknologi for å støtte nye, storstilte initiativer.

Quantum definerer sin vekst med tre horisonter:

- Horisont 1, også kalt nå eller på kort siktinkluderer tilfeller av transaksjonsbruk som kredittscoring, kjøretøyruting, kjemisk design, kjemi og prediksjon av stoff/proteinstruktur.

- Horisont 2, også kalt nær siktfølger med oljeprosessering og frakt, raffineringsprosesser, boring, husdyrhold, avbruddshåndtering og forsyningskjedespørsmål, investeringsrisikoanalyse, akselerasjon av kliniske forsøk, optimalisering av produksjon og fabrikasjon.

- Horisont 3, også kalt fremtidsrettetbestår av seismisk avbildning, forbrukeranbefaling med økonomisk analyse, sykdomsrisikoprediksjon og konstruksjonsdesign for bygninger.

Hvorfor betyr noe av dette?

Løftet om kvantedatamaskinen har kommet i lang tid – og konseptet er nå i ferd med å bli en realitet. Bruken av skalering av qubits i virkelige miljøer viser reelt potensial.

I følge Investopedia, “Kvanteberegning er et databehandlingsområde fokusert på å utvikle datateknologi basert på kvanteteoriens prinsipper (som forklarer oppførselen til energi og materiale på atom- og subatomært nivå).” Når vi ser på dagens datamaskiner, er de designet for å kode informasjon i biter som bruker verdier på 1 eller 0, og begrenser derfor deres evne til å oppnå dette neste prosesseringsnivået. Quantum er en helt ny måte å regne på som skiller seg vesentlig fra det vi gjør i dag på tradisjonelle klassiske systemer.

Det er mange selskaper som prøver å komme foran denne “bølgen” fordi kvanteprosessering er utrolig rask. Å løse dagens problemer ville bli fullført på en brøkdel av tid. Imidlertid fungerer ikke alle brukstilfeller med kvante. De tradisjonelle systemene sameksisterer med kvantesystemer nå og vil fortsette å gjøre det i fremtiden.

ESG er en avdeling av TechTarget.